刚刚,Mistral AI最新磁力链放出!8x22B MoE模型,281GB解禁

刚刚,Mistral AI最新磁力链放出!8x22B MoE模型,281GB解禁一条磁力链,Mistral AI又来闷声不响搞事情。

一条磁力链,Mistral AI又来闷声不响搞事情。

刚刚,Mistral AI 的模型又更新了。 这次开源一如既往地「突然」,是在一个叫做 Cerebral Valley 的黑客松活动上公布的。

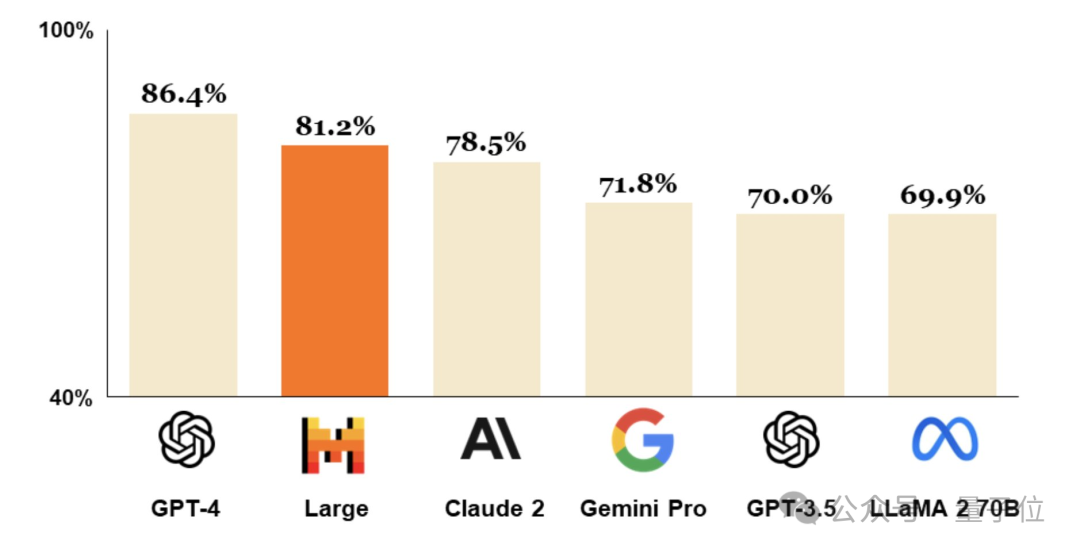

成立仅9个月,法国Mistral AI拿出仅次于GPT-4的大模型。

2月26日,总部位于巴黎的人工智能公司Mistral AI发布尖端文本生成模型Mistral Large。该模型达到了顶级的推理能力,可用于复杂的多语言推理任务,包括文本理解、转换和代码生成。

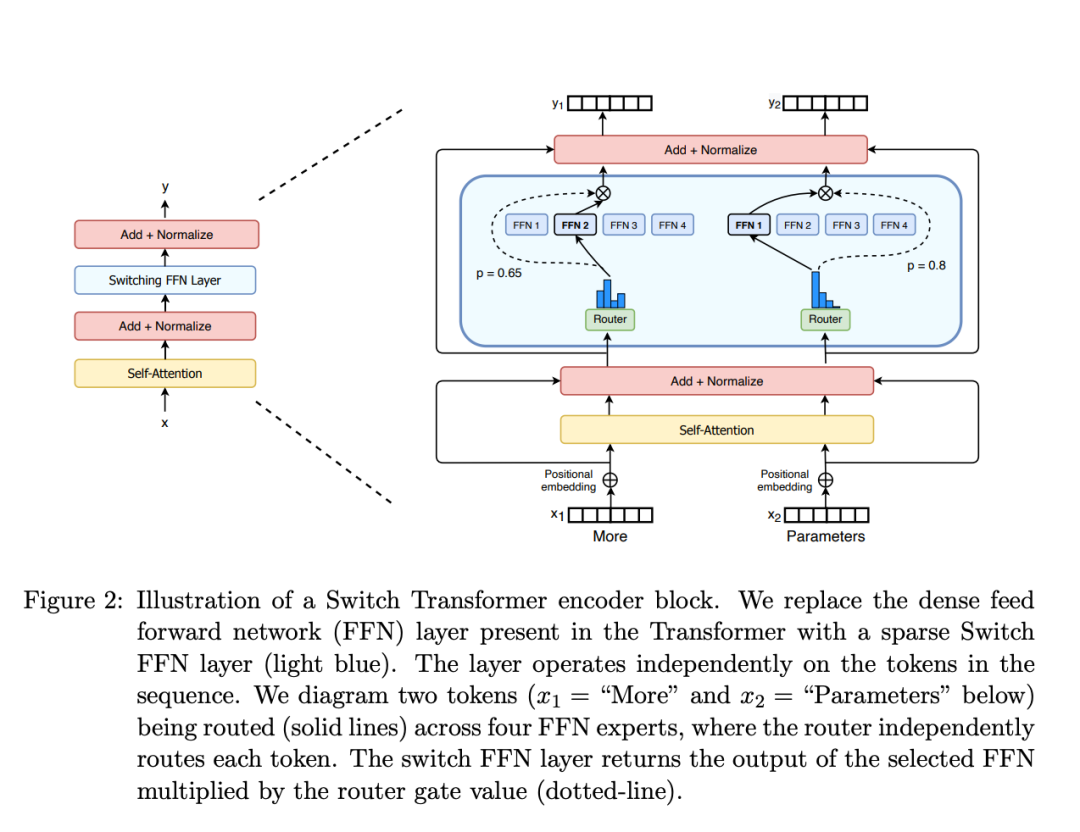

本文将介绍 MoE 的构建模块、训练方法以及在使用它们进行推理时需要考虑的权衡因素。

2023年,有超过10家AI初创公司接受了传统科技巨头的大额投资,不断建立并且强化了微软—OpenAI式的合作关系,甚至引发了英美两国的监管机构的关注。

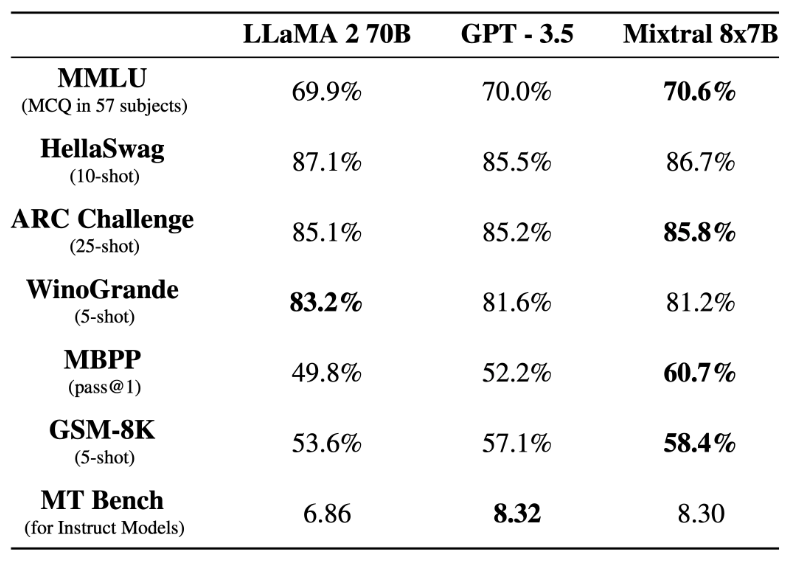

爆火社区的Mixtral 8x7B模型,今天终于放出了arXiv论文!所有模型细节全部公开了。

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

彭博社报道,Mistral 正在完成 4.87 亿美元的融资,估值 20 亿美元,其中英伟达、Salesforce 参与,a16z 领投。

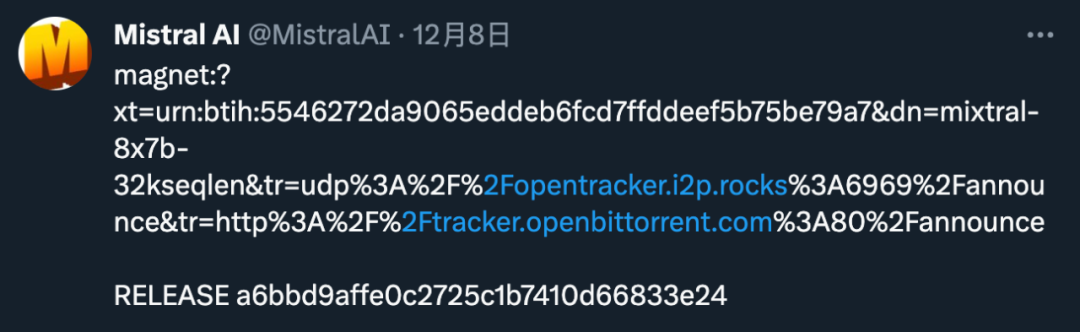

「高端」的开源,往往采用最朴素的发布方式。昨天,Mistral AI 在 X 平台甩出一条磁力链接,宣布了新的开源动作。